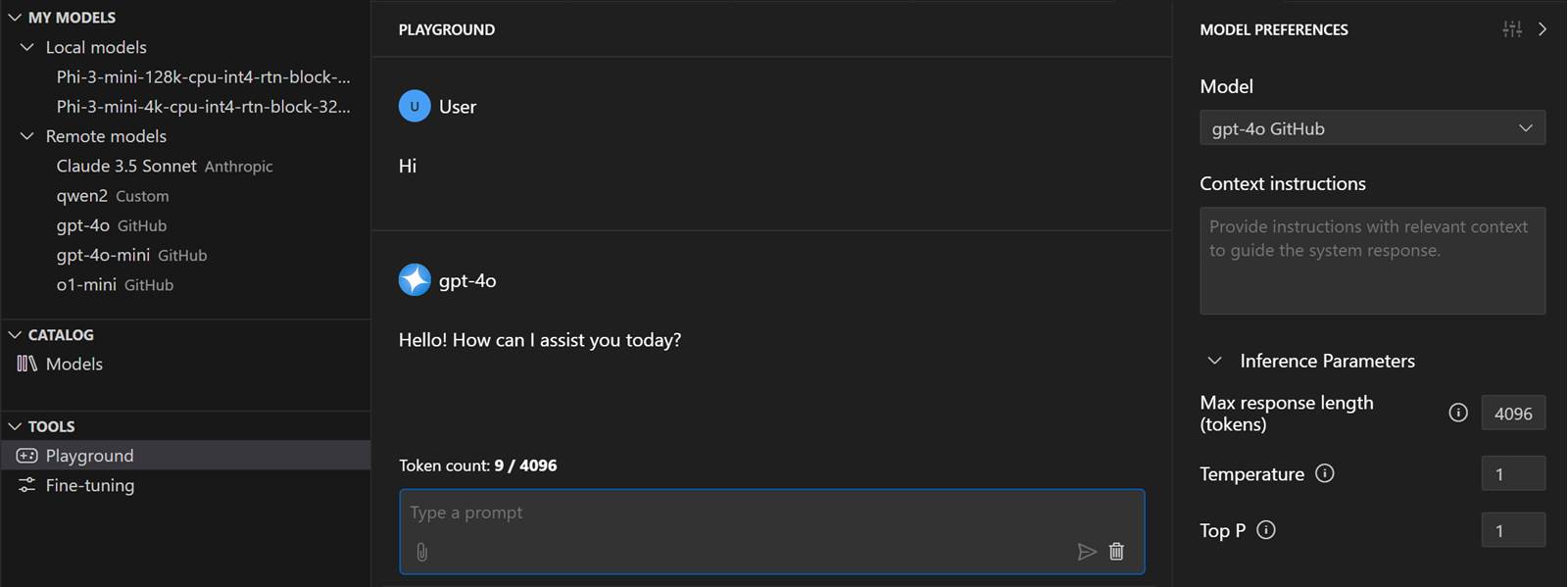

AI 工具包中的模型演练场

AI 工具包演练场提供了一个交互式环境,用于试验生成式 AI 模型。您可以测试各种提示、调整模型参数、比较不同模型的响应,并通过附加不同类型的输入文件来探索多模态功能。

在演练场中测试模型

访问演练场

- 在 AI 工具包视图中,选择工具 > 演练场

- 从模型目录中的模型卡中选择在演练场中试用

- 双击我的模型中的模型以在演练场中打开它

要在演练场中测试模型,请按照以下步骤操作

- 在模型首选项中,从下拉列表中选择一个模型。

- (可选)添加系统提示以指导模型响应。

- (可选)配置所选模型的可用模型参数。

- 在聊天输入框中输入聊天提示

演练场中的本地模型执行

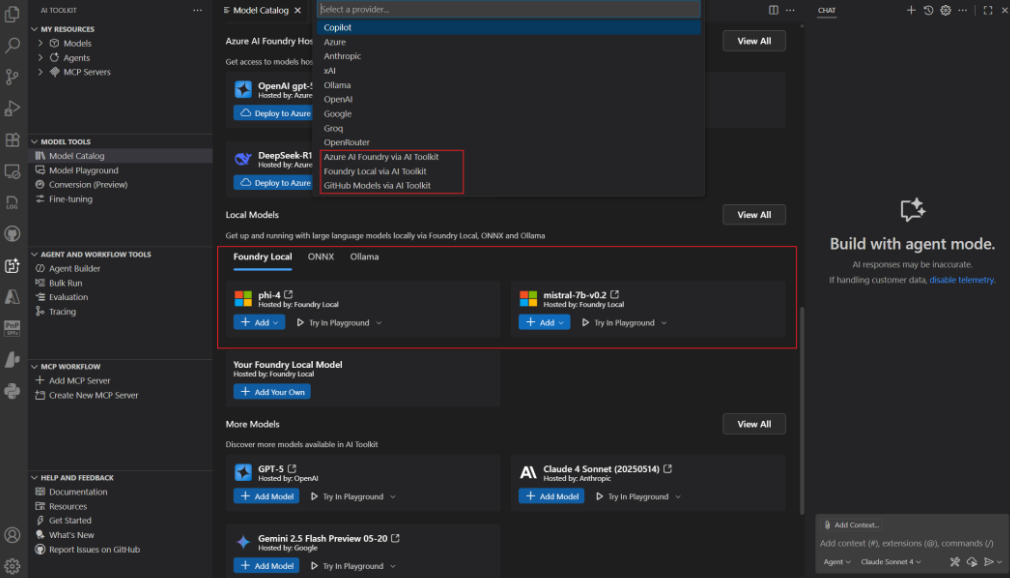

AI 工具包支持在演练场中运行本地模型。您可以从模型首选项面板中的模型下拉列表中选择一个本地模型。

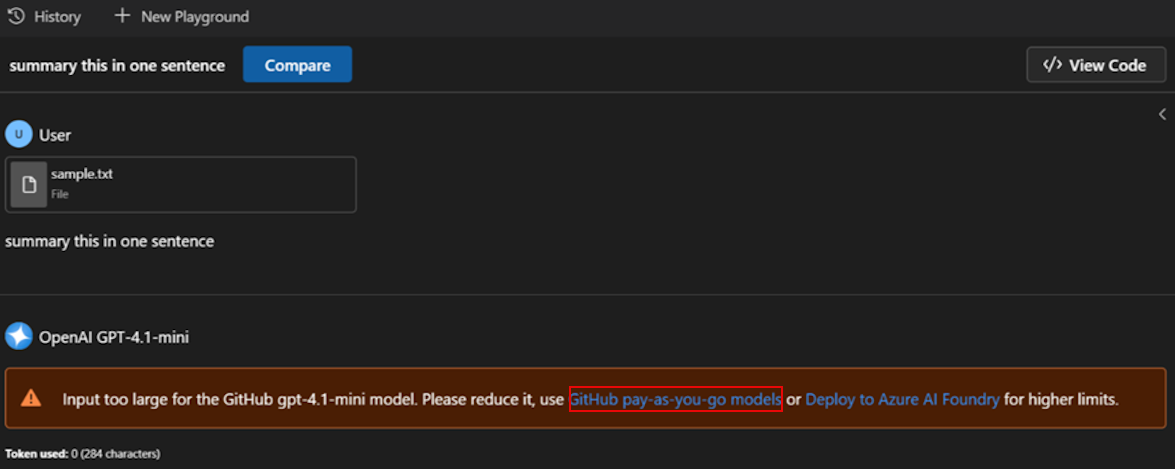

GitHub 即用即付模型支持

AI 工具包现在支持 GitHub 即用即付模型,因此您可以在超出免费层限制后继续工作。

-

当您达到 GitHub 的模型使用限制时,AI 工具包会显示一个警告,其中包含指向 GitHub 付费使用文档的链接。

-

在您的 GitHub 设置中开启模型计费(需要登录您的 GitHub 帐户)。

-

启用计费后,继续在演练场或代理生成器中使用模型,而无需更改您的工作流程。

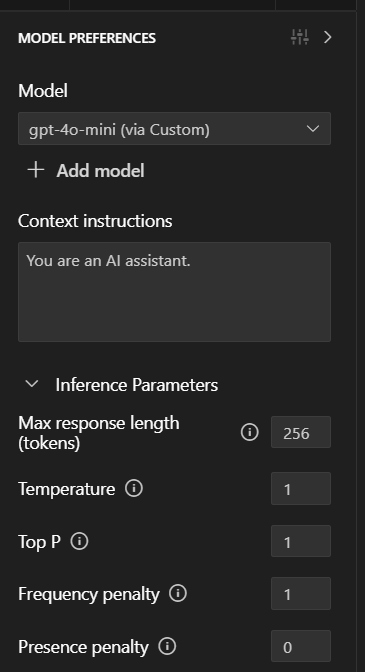

模型首选项

模型首选项面板允许您选择用于演练场交互的模型、设置系统提示以指导模型的行为以及配置所选模型的模型参数。

选择模型

模型首选项面板中的下拉列表显示您已添加到 AI 工具包中的模型。您可以选择浏览模型以打开模型目录并添加更多模型。

系统提示

系统提示是预定义指令,用于指导模型的行为和响应风格。您可以在输入文本区域中添加、编辑或删除系统提示,以影响模型生成响应的方式。

配置推理参数

可用参数取决于模型类型和发布者。常见参数包括

- 温度:控制模型输出的随机性。较低的值使输出更具确定性。较高的值引入更多可变性。

- Top P:通过限制所选标记的累积概率来控制输出的多样性。较低的值会产生更集中的响应。较高的值允许更多样化的输出。

- 最大响应长度(标记):设置模型响应中的最大标记数。这限制了生成文本的长度。

- 频率惩罚:降低模型在响应中重复相同标记的可能性。较高的值会阻止重复。

- 存在惩罚:鼓励模型在响应中引入新的主题或概念。较高的值会促进生成文本的多样性。

聊天提示

聊天提示是您提供给模型的输入文本。您可以输入问题、陈述或任何您希望模型响应的文本。模型根据提供的提示以及配置的系统提示和参数生成响应。

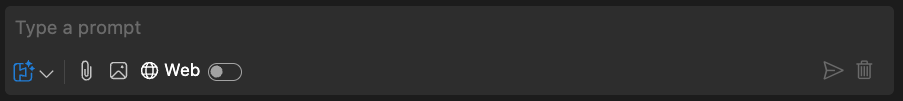

聊天提示输入框中的可用功能

- 发送:将聊天提示提交给模型进行处理。

- 清除:清除聊天提示输入框。

- 文件附件:为多模态模型附加文件到聊天提示。

- 图片附件:为多模态模型附加图片到聊天提示。

- 网页搜索:执行网页搜索以查找与聊天提示相关的信息。

- 模式切换:切换使用 AI 功能的不同模式。

切换模式

您可以在聊天提示输入框中切换不同模式

- 使用模型原生支持的 AI 功能:此模式允许您使用所选模型的原生功能,例如网页搜索或文件附件。

- 使用所有 AI 功能:此模式允许您使用 AI 工具包实现的 AI 功能,例如文件附件,无论模型是否具有原生功能。

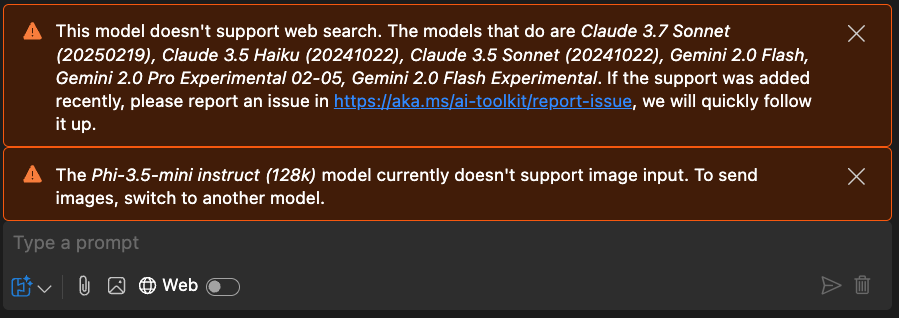

如果所选模型或 AI 工具包不支持某项功能,聊天提示输入框上方会显示警告。警告建议您切换到支持该功能的其他模型。

模型响应

模型响应显示在聊天提示输入框上方。在您输入聊天提示之前,演练场会显示一个欢迎屏幕,其中包含三个入门提示,供您开始使用演练场。

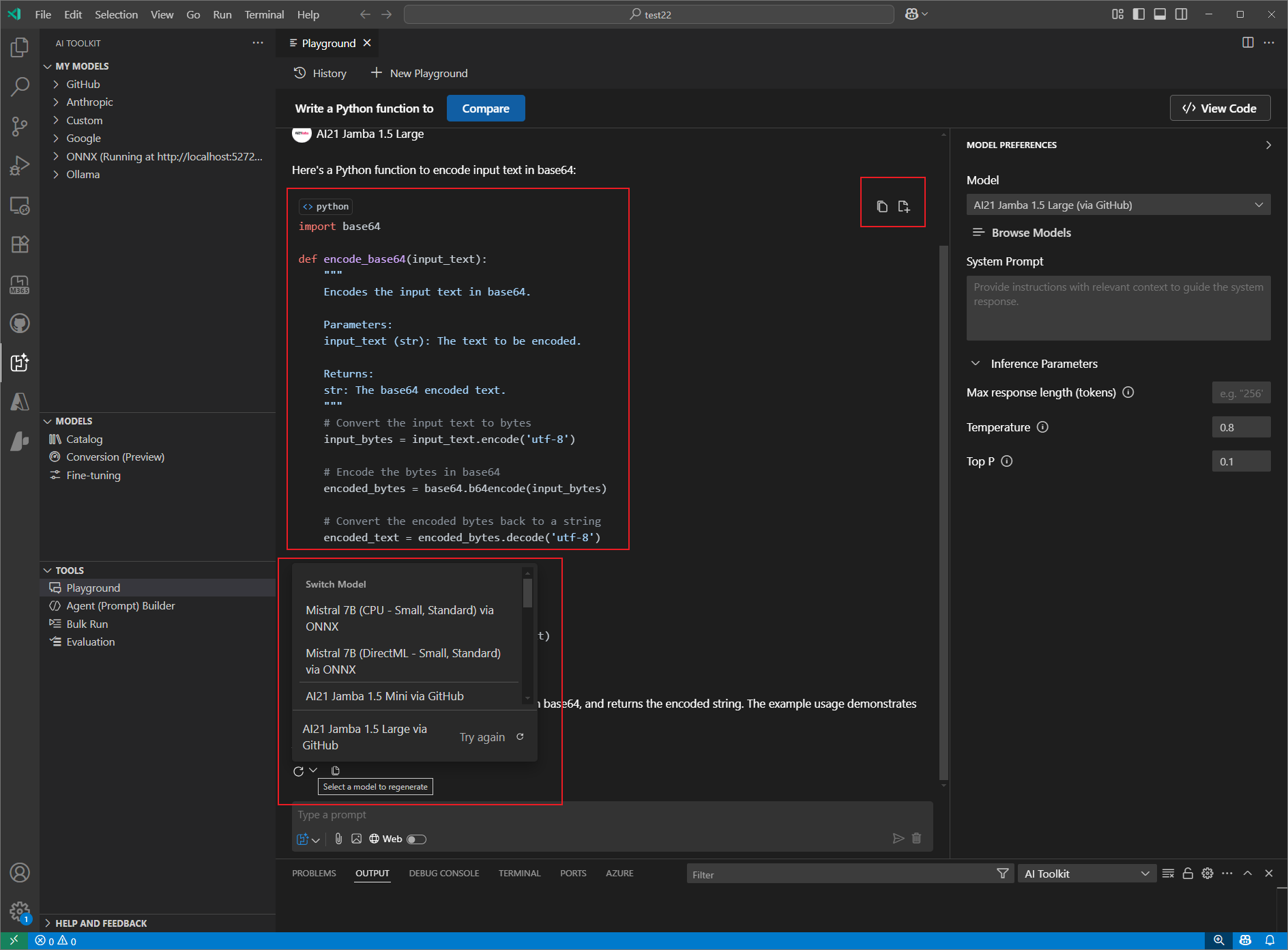

模型响应区域中的可用功能

- 复制响应:将模型的响应文本复制到剪贴板。

- 重新生成响应:根据相同的提示重新生成模型的响应,或使用另一个模型重新生成响应。

- 复制代码:将响应中生成的代码复制到剪贴板或插入到新文件中。

- 渲染:演练场支持渲染模型响应中的代码片段、图像、Markdown、LaTeX 和其他内容。

- 标记计数:显示模型响应中使用的标记数量。这有助于您了解模型的成本和性能。

工具栏

演练场中的工具栏提供对各种操作和功能的快速访问:

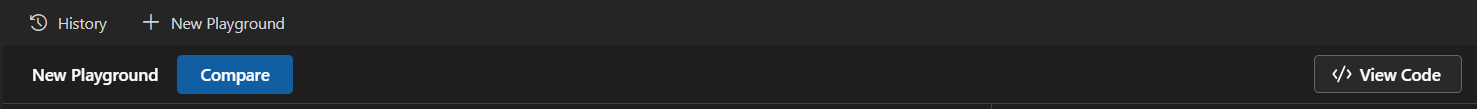

- 新建演练场:创建新的演练场会话。

- 历史记录:查看、重命名、删除和切换到聊天历史记录。

- 自动命名:聊天会话名称根据用户提示自动生成。

- 比较:并排比较不同模型的响应。

- 查看代码:查看 LLM 集成中为聊天提示生成的代码。

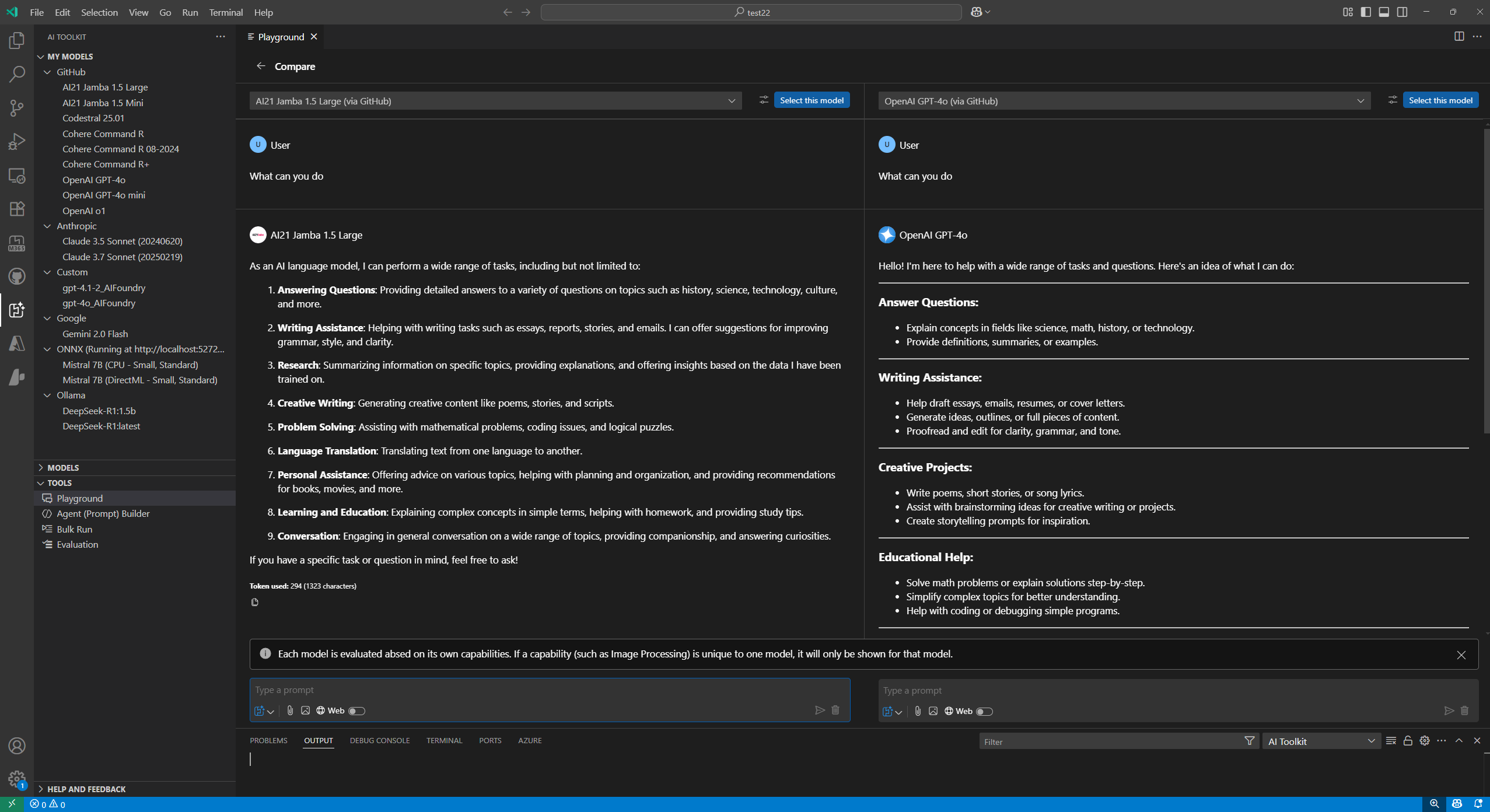

比较模型响应

比较功能允许您并排比较不同模型的响应。这对于评估不同模型在相同提示下的性能非常有用。

比较模型响应

- 选择工具栏中的比较按钮。

- 从下拉列表中选择您要比较的模型。

- 在其中一个输入框中输入相同的聊天提示。您的提示将复制到其他输入框中。

- 选择发送以将提示提交给所有选定的模型。

- 每个模型的响应并排显示,以便于比较。

对于您正在比较的每个模型,您可以

- 将响应文本复制到剪贴板。

- 配置所选模型的模型参数。

- 继续与所选模型聊天。

您学到了什么

在本文中,您学习了如何

- 使用 AI 工具包演练场与生成式 AI 模型交互。

- 在演练场中测试模型,配置系统提示和参数,并通过附加文件探索多模态功能。

- 使用“比较”功能评估不同模型在相同提示下的性能,并并排查看响应。

- 使用聊天提示输入框发送提示、附加文件或图像、执行网页搜索以及切换 AI 功能的模式。

- 查看模型响应,复制或重新生成响应,并渲染代码片段、图像、Markdown 和 LaTeX。

- 跟踪模型响应中的标记计数,以了解成本和性能。

- 使用“模型首选项”面板选择模型、设置系统提示和调整推理参数。

- 使用工具栏创建新的演练场会话、查看和管理聊天历史记录、自动命名会话、比较模型和查看生成的代码。

- 管理聊天历史记录,包括查看、重命名、删除和切换会话。