AI 工具包中的构建代理和提示

Agent Builder 以前称为 Prompt Builder。更新后的名称更好地反映了该功能的功能及其构建代理的重点。

AI 工具包中的 Agent Builder 简化了构建代理的工程工作流,包括提示工程以及与 MCP 服务器等工具的集成。它有助于完成常见的提示工程任务。

- 实时迭代和优化

- 提供对代码的便捷访问,以便通过 API 实现无缝的大型语言模型 (LLM) 集成。

Agent Builder 还通过工具使用增强了智能应用程序的功能。

- 连接到现有的 MCP 服务器

- 从模板构建新的 MCP 服务器

- 使用函数调用连接到外部 API 和服务

创建、编辑和测试提示

要访问 Agent Builder,请使用以下任一选项:

- 在 AI 工具包视图中,选择 **Agent Builder**。

- 在模型目录的模型卡片中,选择 **在 Agent Builder 中试用**。

- 在“我的资源”视图中,“**模型**”下,右键单击模型并选择“**加载到 Agent Builder**”。

要在 Agent Builder 中测试提示,请执行以下步骤:

-

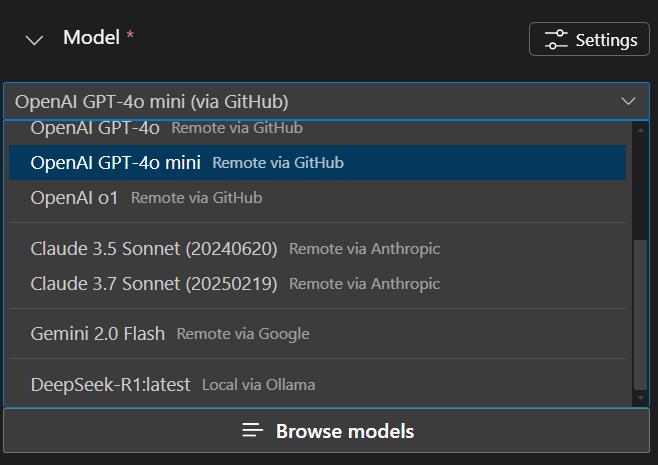

如果您尚未选择模型,请在 Agent Builder 的“**模型**”下拉列表中选择一个。您还可以选择“**浏览模型**”以从模型目录中添加其他模型。

-

输入代理指令。

使用“**指令**”字段确切地告诉您的代理要执行什么以及如何执行。列出具体任务,按顺序排列,并添加任何特殊指令,例如语气或互动方式。

-

通过观察模型响应并更改指令来迭代您的指令。

-

使用

语法在指令中添加动态值。例如,添加一个名为user_name的变量,并在指令中像这样使用它:按名称问候用户:。 -

在“**变量**”部分为变量提供值。

-

在文本框中输入提示,然后选择发送图标以测试您的代理。

-

观察模型的响应,并对指令进行任何必要的调整。

使用 MCP 服务器

MCP 服务器是一种允许您连接到外部 API 和服务的工具,它使您的代理能够执行超出文本生成的额外操作。例如,您可以使用 MCP 服务器访问数据库、调用 Web 服务或与其他应用程序交互。

使用 Agent Builder 来发现和配置精选的 MCP 服务器,连接到现有的 MCP 服务器,或从模板构建新的 MCP 服务器。

使用 MCP 服务器可能需要 Node 或 Python 环境。AI 工具包会验证您的环境,以确保已安装所需的依赖项。安装后,使用命令 npm install -g npx 来安装 npx。如果您偏好 Python,我们建议使用 uv。

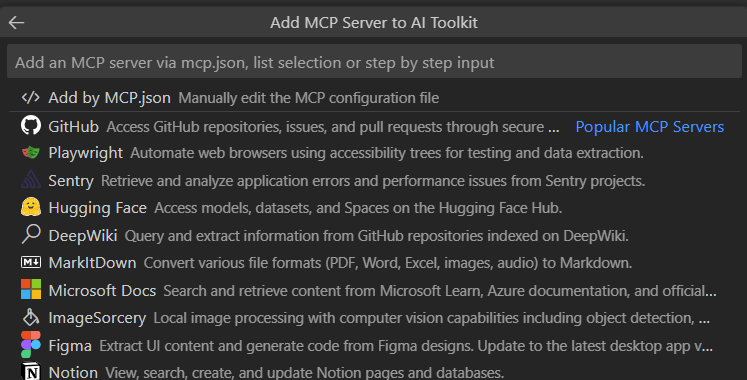

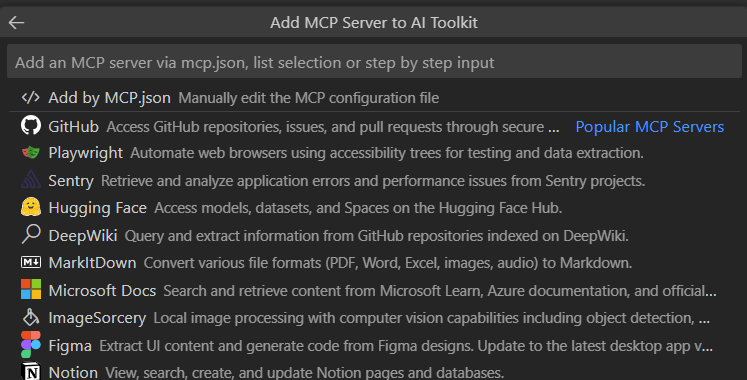

配置精选的 MCP 服务器

AI 工具包提供了一个精选的 MCP 服务器列表,您可以使用它们来连接到外部 API 和服务。

要从精选选项中配置 MCP 服务器,请执行以下步骤:

-

在“**工具**”部分,选择 “**+ MCP 服务器**”,然后在“快速选择”中选择“**MCP 服务器**”。

-

从下拉列表中选择“**找不到?浏览更多 MCP 服务器**”。

-

选择满足您需求的 MCP 服务器。

-

MCP 服务器已添加到您的代理的“**工具**”下的“**MCP**”子部分。

从 VS Code 中选择工具

-

在“**工具**”部分,选择 “**+ MCP 服务器**”,然后在“快速选择”中选择“**MCP 服务器**”。

-

从下拉列表中选择“**使用 Visual Studio Code 中已添加的工具**”。

-

选择要使用的工具。

-

名为

VSCode Tools的 MCP 服务器工具已添加到您的代理的“**工具**”下的“**MCP**”子部分。

使用现有的 MCP 服务器

在这些 参考服务器 中查找 MCP 服务器。

要使用现有的 MCP 服务器,请执行以下步骤:

-

在“**MCP 工作流**”部分,选择 “**+ 添加 MCP 服务器**”。

-

或者在 Agent Builder 的“**工具**”部分,选择 “+”图标为您的代理添加工具,然后在“快速选择”中选择“**+ 添加服务器**”。

-

在“快速选择”中选择“**MCP 服务器**”。

-

选择“**连接到现有 MCP 服务器**”。

-

向下滚动到下拉列表的底部以获取连接到 MCP 服务器的选项。

- **命令 (stdio)**:运行实现 MCP 协议的本地命令。

- **HTTP (HTTP 或服务器发送事件)**:连接到实现 MCP 协议的远程服务器。

-

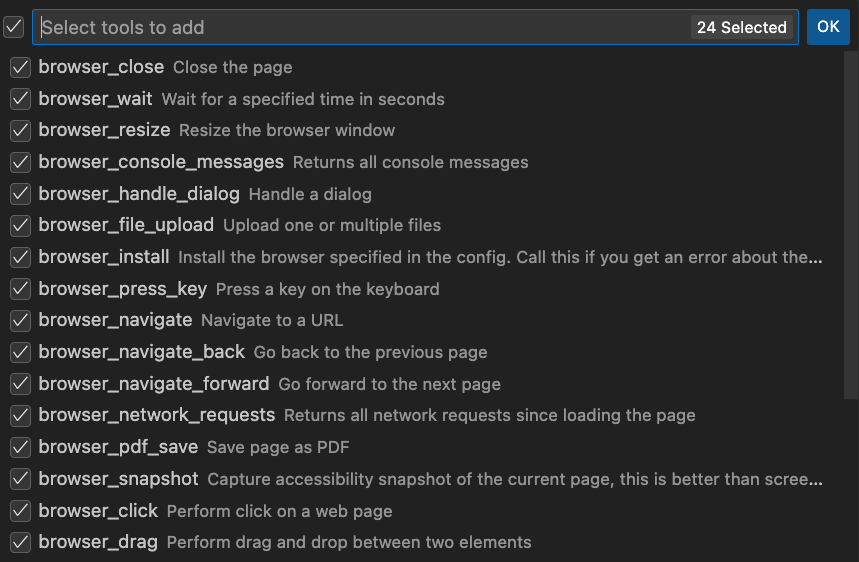

如果 MCP 服务器有多个可用工具,请选择要使用的工具。

-

在文本框中输入您的提示,然后选择发送图标以测试连接。

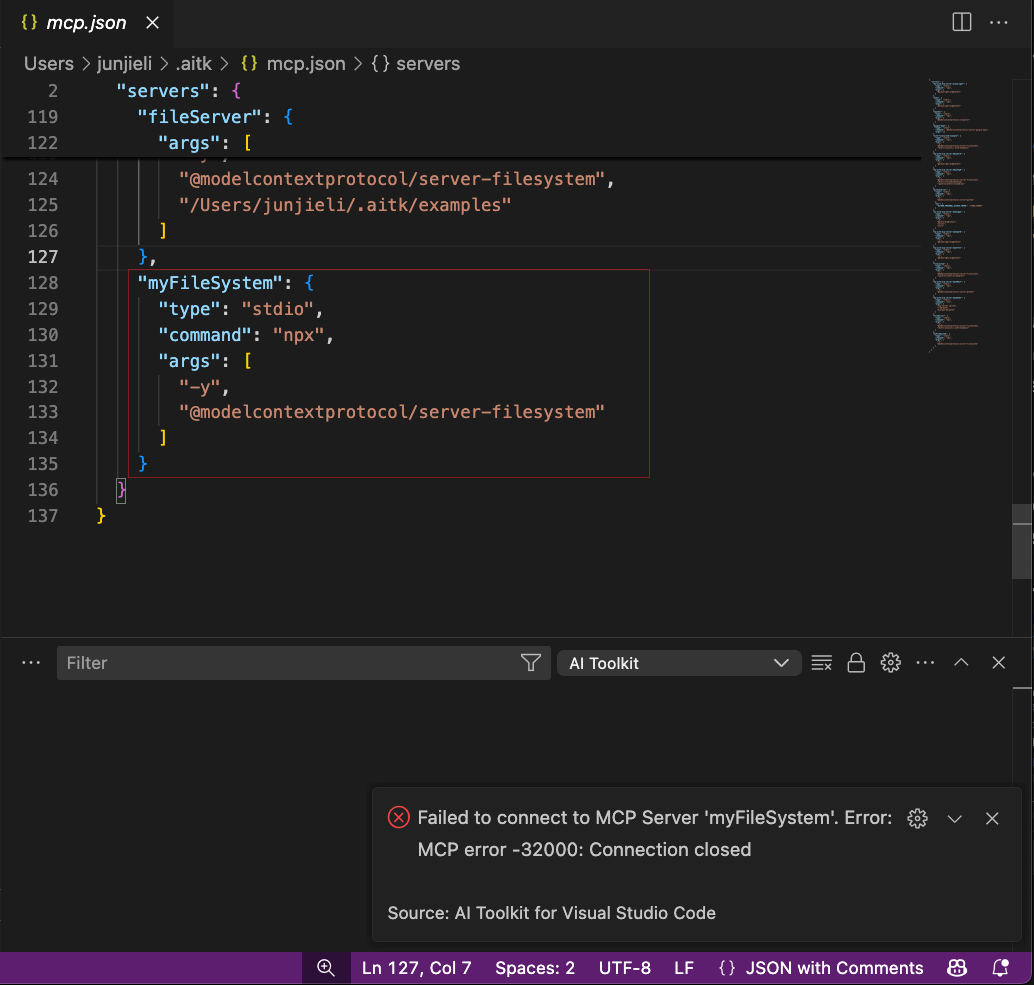

以下是在 AI 工具包中配置 Filesystem 服务器的示例。

-

在“**工具**”部分,在“快速选择”中选择 “**+ MCP 服务器**”。

-

从下拉列表中选择“**找不到?浏览更多 MCP 服务器**”。

-

向下滚动到下拉列表的底部,然后选择“**命令 (stdio)**”。

注意某些服务器使用 Python 运行时和

uvx命令。过程与使用npx命令相同。 -

导航到 服务器说明,并找到

npx部分。 -

将

command和args复制到 AI 工具包中的输入框中。对于 Filesystem 服务器示例,它是npx -y @modelcontextprotocol/server-filesystem /Users/<username>/.aitk/examples。 -

输入服务器的 ID。

-

可以选择输入其他环境变量。某些服务器可能需要其他环境变量,例如 API 密钥。在这种情况下,AI 工具包将在添加工具阶段失败,并且会打开一个名为

mcp.json的文件,您可以在其中根据每个服务器提供的说明输入所需的服务器详细信息。 完成配置后:1. 导航回“**工具**”部分,选择 “**+ MCP 服务器**” 1. 从下拉列表中选择您配置的服务器。

完成配置后:1. 导航回“**工具**”部分,选择 “**+ MCP 服务器**” 1. 从下拉列表中选择您配置的服务器。 -

选择要使用的工具。

AI 工具包还提供了一个模板,用于帮助您构建新的 MCP 服务器。该模板包含 MCP 协议的基本实现,您可以对其进行自定义以满足您的需求。

构建新的 MCP 服务器

要构建新的 MCP 服务器,请执行以下步骤:

- 在“**MCP 工作流**”部分,选择 “**创建新 MCP 服务器**”。

- 从下拉列表中选择一种编程语言:**Python** 或 **TypeScript**。

- 选择一个文件夹来创建新的 MCP 服务器项目。

- 输入 MCP 服务器项目的名称。

创建 MCP 服务器项目后,您可以自定义实现以满足您的需求。该模板包含 MCP 协议的基本实现,您可以修改它以添加自己的功能。

您还可以使用 Agent Builder 来测试 MCP 服务器。Agent Builder 将提示发送到 MCP 服务器并显示响应。

按照以下步骤测试 MCP 服务器:

要在本地开发计算机上运行 MCP 服务器,您需要:在您的计算机上安装 Node.js 或 Python。

-

打开 VS Code 调试面板。选择“**在 Agent Builder 中调试**”或按

F5启动 MCP 服务器的调试。 -

服务器将自动连接到 Agent Builder。

-

使用 AI 工具包 Agent Builder,根据以下指令启用代理:

- "你是一名天气预报专业人士,可以根据给定的地点提供天气信息。"。

-

在提示框中输入提示“西雅图的天气如何?”,然后选择发送图标以使用该提示测试服务器。

-

在 Agent Builder 中观察 MCP 服务器的响应。

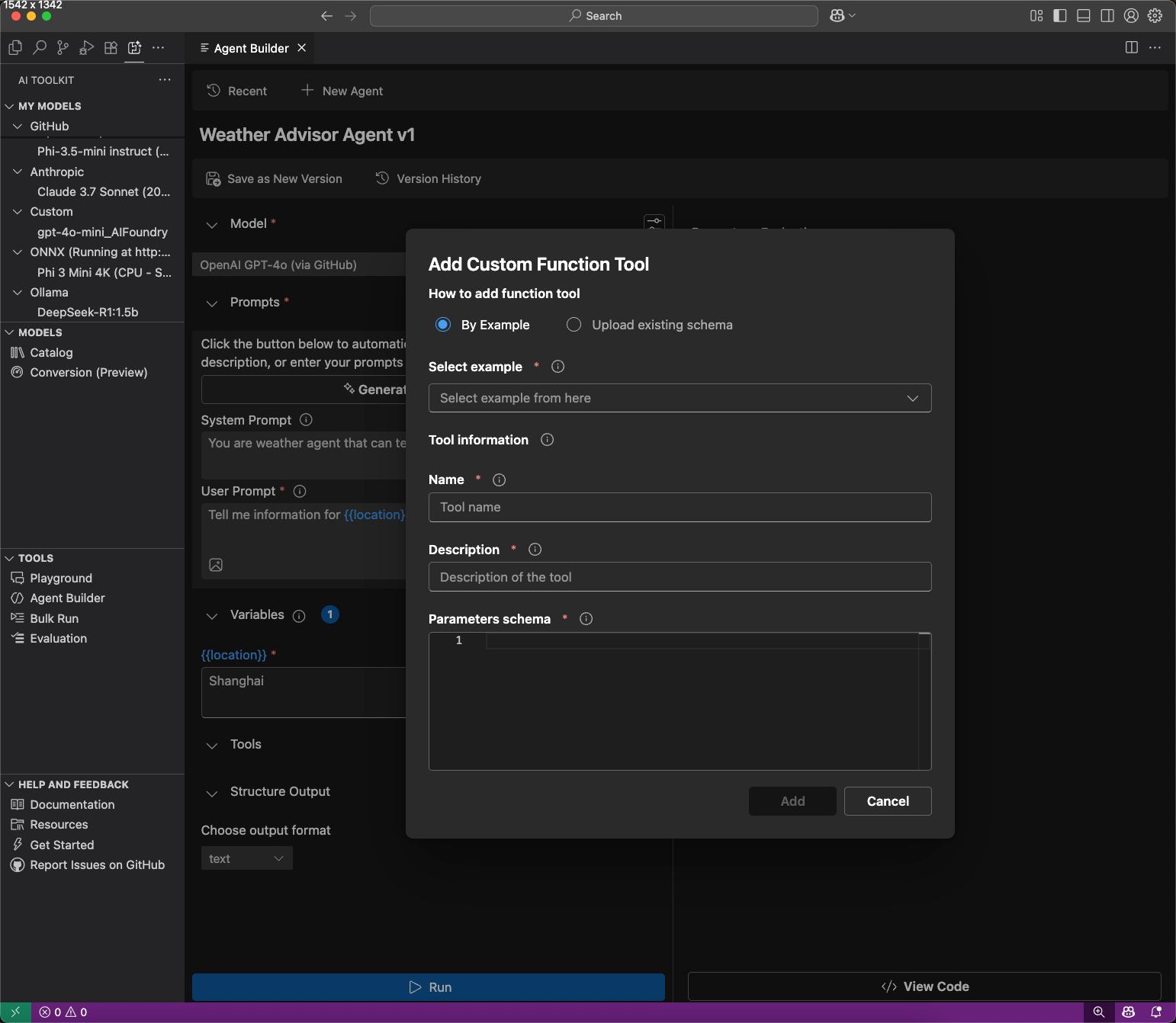

使用函数调用

函数调用将您的代理连接到外部 API 和服务。

- 在“**工具**”中,选择“**添加工具**”,然后选择“**自定义工具**”。

- 选择如何添加工具:

- **按示例**:从 JSON 架构示例添加。

- **上传现有架构**:上传 JSON 架构文件。

- 输入工具名称和描述,然后选择“**添加**”。

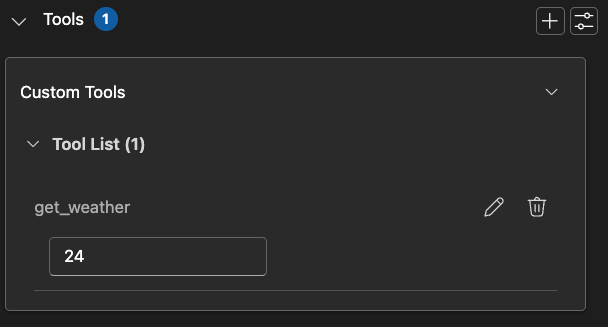

- 在工具卡中提供模拟响应。

- 运行带有函数调用工具的代理。

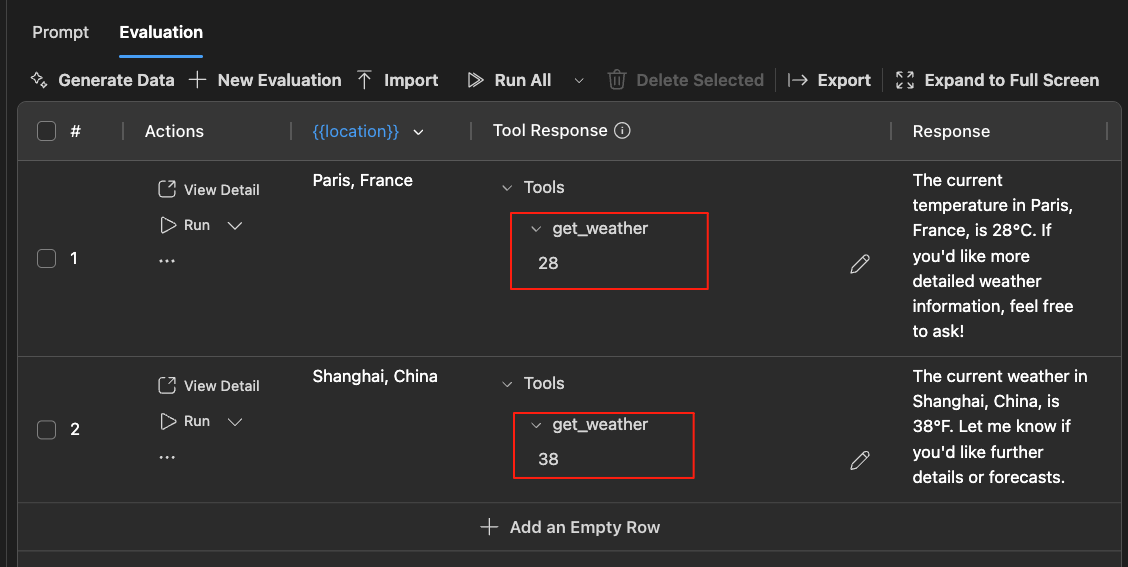

在“**评估**”选项卡中使用函数调用工具,方法是为测试用例输入模拟响应。

将提示工程集成到您的应用程序中

在尝试了模型和提示之后,您可以使用自动生成的 Python 代码立即开始编码。

要查看 Python 代码,请执行以下步骤:

-

选择“**查看代码**”。

-

对于托管在 GitHub 上的模型,选择您想要使用的推理 SDK。

AI 工具包使用提供商的客户端 SDK 为您选择的模型生成代码。对于 GitHub 托管的模型,您可以选择要使用的推理 SDK:Agent Framework SDK 或来自模型提供商的 SDK,例如 OpenAI SDK 或 Mistral API。

-

生成的代码片段显示在新编辑器中,您可以将其复制到您的应用程序中。

要进行模型身份验证,通常需要来自提供商的 API 密钥。要访问 GitHub 托管的模型,请在您的 GitHub 设置中 生成个人访问令牌 (PAT)。

您学到了什么

在本文中,您学习了如何

- 使用适用于 VS Code 的 AI 工具包来测试和调试您的代理。

- 发现、配置和构建 MCP 服务器,将您的代理连接到外部 API 和服务。

- 设置函数调用,将您的代理连接到外部 API 和服务。

- 实现结构化输出,以从您的代理中获得可预测的结果。

- 使用生成的代码片段将提示工程集成到您的应用程序中。

后续步骤

- 运行评估作业以运行流行的评估器。