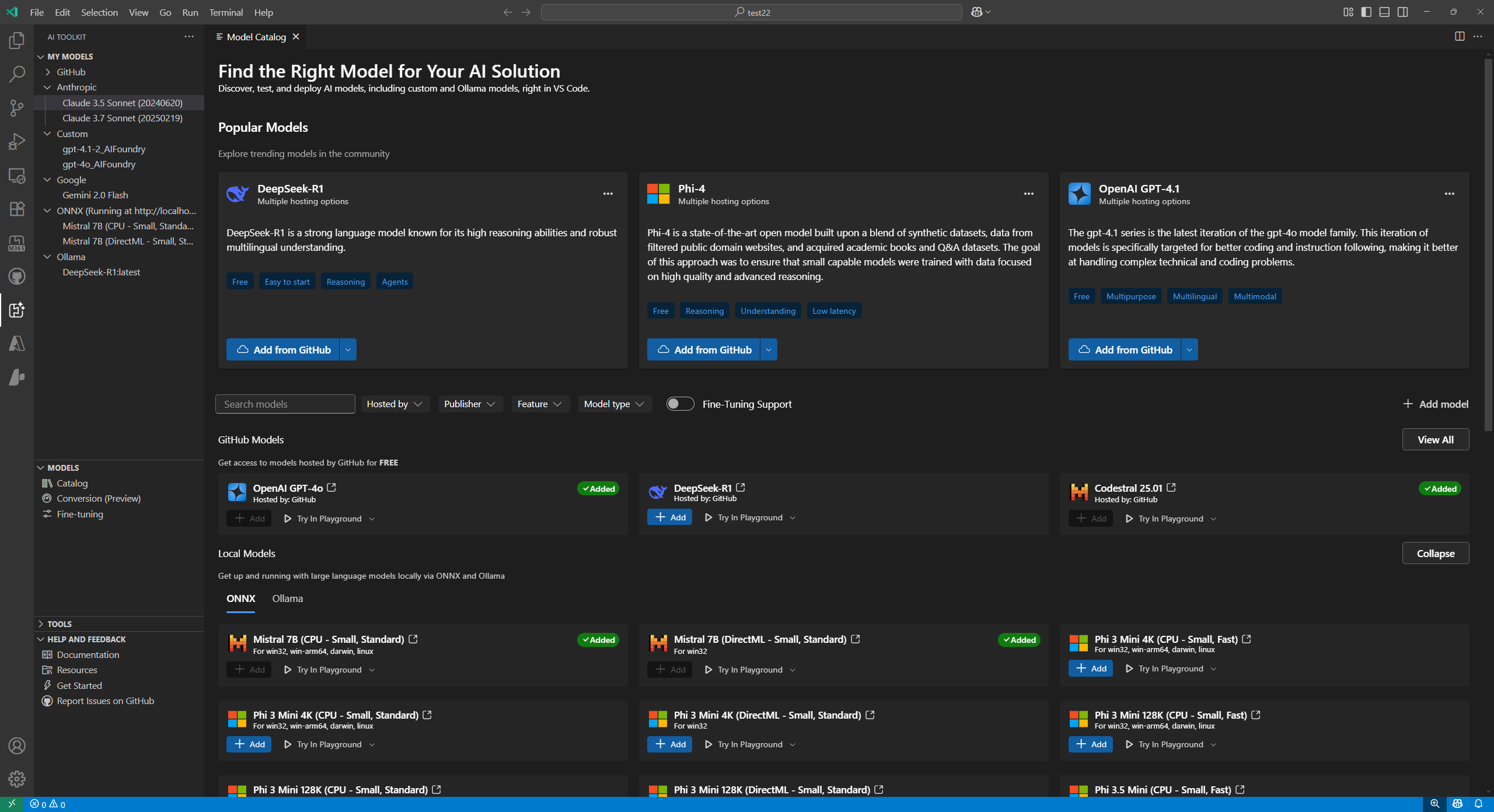

在 AI Toolkit 中探索模型

AI Toolkit 为各种生成式 AI 模型提供全面支持,包括小型语言模型 (SLM) 和大型语言模型 (LLM)。

在模型目录中,您可以探索和使用来自多个托管源的模型

- 托管在 GitHub 上的模型,例如 Llama3、Phi-3 和 Mistral,包括按使用量付费的选项。

- 由发布商直接提供的模型,包括 OpenAI 的 ChatGPT、Anthropic 的 Claude 和 Google 的 Gemini。

- 托管在 Microsoft Foundry 上的模型。

- 从 Ollama 和 ONNX 等存储库下载到本地的模型。

- 通过自带模型 (BYOM) 集成访问自定义的自托管模型或外部部署模型。

直接从模型目录将模型部署到 Foundry,从而简化您的工作流程。

使用 Microsoft Foundry、Foundry Local 和已添加到 AI Toolkit 的 GitHub 模型以及 GitHub Copilot。有关更多信息,请查看 更改聊天对话的模型。

查找模型

在模型目录中查找模型

-

在活动栏中选择 AI Toolkit 视图

-

选择 MODELS > Catalog 以打开模型目录

-

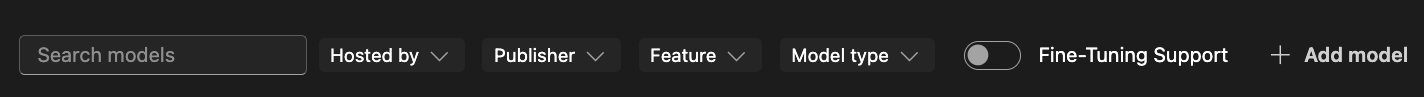

使用筛选器减少可用模型列表

- 由...托管:AI Toolkit 支持 GitHub、ONNX、OpenAI、Anthropic、Google 作为模型托管源。

- 发布商:AI 模型的发布商,例如 Microsoft、Meta、Google、OpenAI、Anthropic、Mistral AI 等。

- 功能:模型支持的功能,例如

文本附件、图像附件、网络搜索、结构化输出等。 - 模型类型:筛选可以在 CPU、GPU 或 NPU 上远程或本地运行的模型。此筛选器取决于本地可用性。

- 微调支持:显示可用于运行微调的模型。

-

按不同类别浏览模型,例如

- 热门模型 是一个精选列表,包含在各种任务和领域中广泛使用的模型。

- GitHub 模型 提供对托管在 GitHub 上的热门模型的便捷访问。最适合快速原型设计和实验。

- ONNX 模型 针对本地执行进行了优化,可以在 CPU、GPU 或 NPU 上运行。

- Ollama 模型 是可以通过 Ollama 在本地运行的热门模型,支持通过 GGUF 量化运行 CPU。

-

或者,使用搜索框按名称或描述查找特定模型

从目录添加模型

从模型目录添加模型

-

在模型目录中找到要添加的模型。

-

在模型卡片上选择 Add

-

添加模型的流程会根据提供商略有不同

-

GitHub:AI Toolkit 要求提供您的 GitHub 凭据才能访问模型存储库。身份验证后,模型将直接添加到 AI Toolkit 中。

注意AI Toolkit 现在 支持 GitHub 按使用量付费模型,因此您可以在超出免费套餐限制后继续工作。

-

ONNX:模型将从 ONNX 下载并添加到 AI Toolkit。

-

Ollama:模型将从 Ollama 下载并添加到 AI Toolkit。

提示您之后可以通过右键单击模型并选择 Edit 来编辑 API 密钥,并在

${HOME}/.aikt/models/my-models/yml文件中查看加密值。

-

OpenAI、Anthropic 和 Google:AI Toolkit 会提示您输入 API 密钥。

-

自定义模型:有关详细说明,请参阅 添加自定义模型 部分。

-

添加后,模型将显示在树状视图的 MY MODELS 下,您可以在 Playground 或 Agent Builder 中使用它。

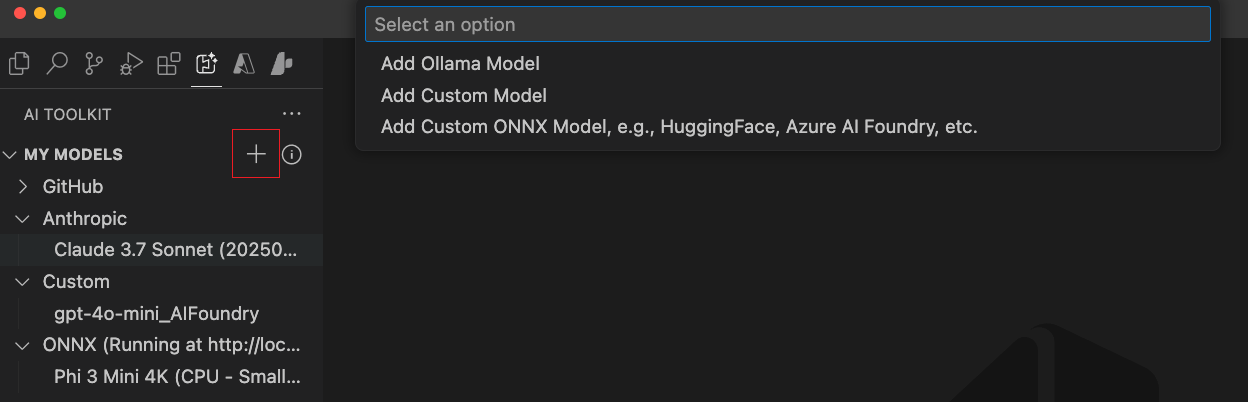

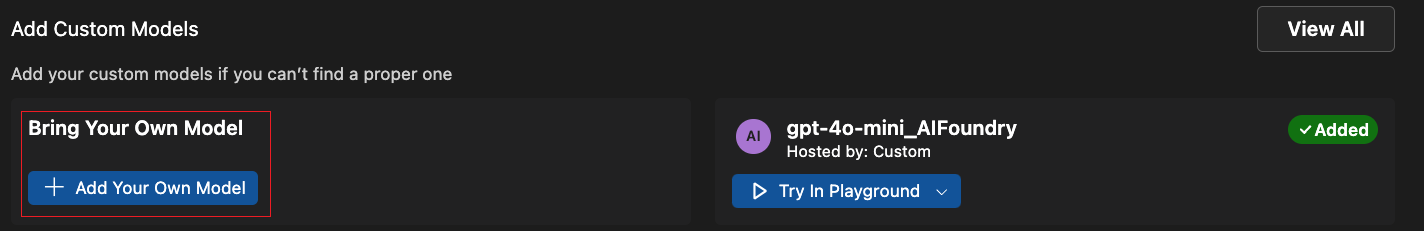

添加自定义模型

您还可以添加自己托管在外部或本地运行的模型。有几种可用选项

- 从 Ollama 库或自定义 Ollama 端点添加 Ollama 模型。

- 添加具有 OpenAI 兼容端点的自定义模型,例如自托管模型或在云服务上运行的模型。

- 使用 AI Toolkit 的 模型转换工具添加自定义 ONNX 模型,例如来自 Hugging Face 的模型。

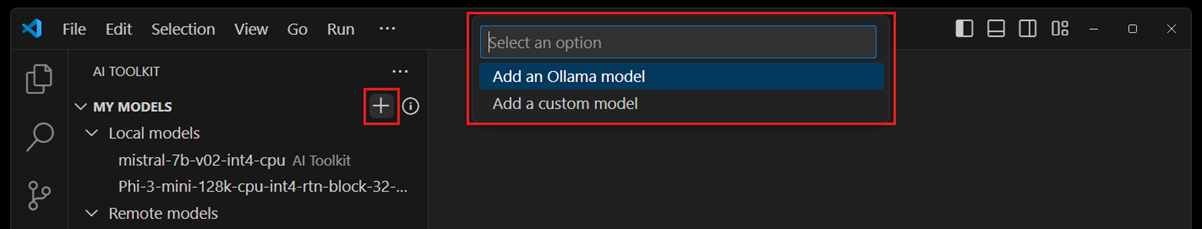

有几个入口点可以将模型添加到 AI Toolkit

-

从树状视图中的 MY MODELS,将其悬停并选择

+图标。

-

从 Model Catalog,选择工具栏上的 + Add model 按钮。

-

从模型目录中的 Add Custom Models 部分,选择 + Add Your Own Model。

添加 Ollama 模型

Ollama 使许多流行的生成式 AI 模型能够通过 GGUF 量化在本地使用 CPU 运行。如果您已在本地计算机上安装了 Ollama 并下载了 Ollama 模型,则可以将其添加到 AI Toolkit 中,在模型 Playground 中使用。

在 AI Toolkit 中使用 Ollama 模型的前提条件

- AI Toolkit v0.6.2 或更高版本。

- Ollama (在 Ollama v0.4.1 上测试)

将本地 Ollama 添加到 AI Toolkit

-

从上述入口点之一中,选择 Add Ollama Model。

-

接下来,选择 Select models from Ollama library

如果您在不同的端点启动 Ollama 运行时,请选择 Provide custom Ollama endpoint 来指定 Ollama 端点。

-

选择要添加到 AI Toolkit 的模型,然后选择 OK

-

现在您应该能在树状视图的模型列表中看到选定的 Ollama 模型。

注意Ollama 模型尚不支持附件。由于我们通过其 OpenAI 兼容端点连接到 Ollama,而它尚不支持附件。

添加具有 OpenAI 兼容端点的自定义模型

如果您有一个自托管或已部署的模型,可通过互联网使用 OpenAI 兼容端点访问,则可以将其添加到 AI Toolkit 并在 Playground 中使用。

- 从上述入口点之一中,选择 Add Custom Model。

- 输入 OpenAI 兼容端点 URL 和所需信息。

添加自托管或本地运行的 Ollama 模型

- 在模型目录中选择 + Add model。

- 在模型快速选择中,选择 Ollama 或 Custom model。

- 输入所需详细信息以添加模型。

添加自定义 ONNX 模型

要添加自定义 ONNX 模型,请首先使用 模型转换工具将其转换为 AI Toolkit 模型格式。转换后,将模型添加到 AI Toolkit。

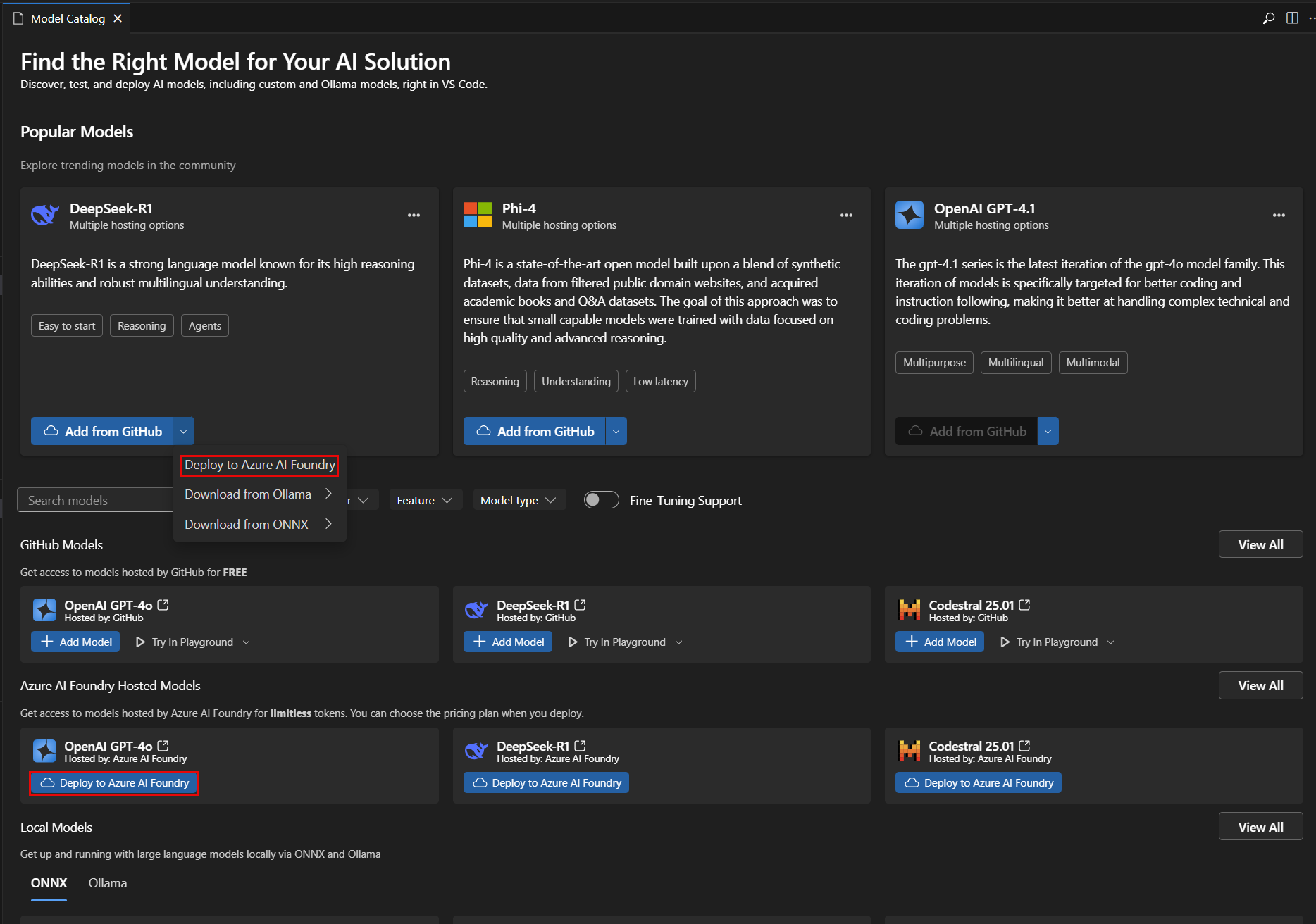

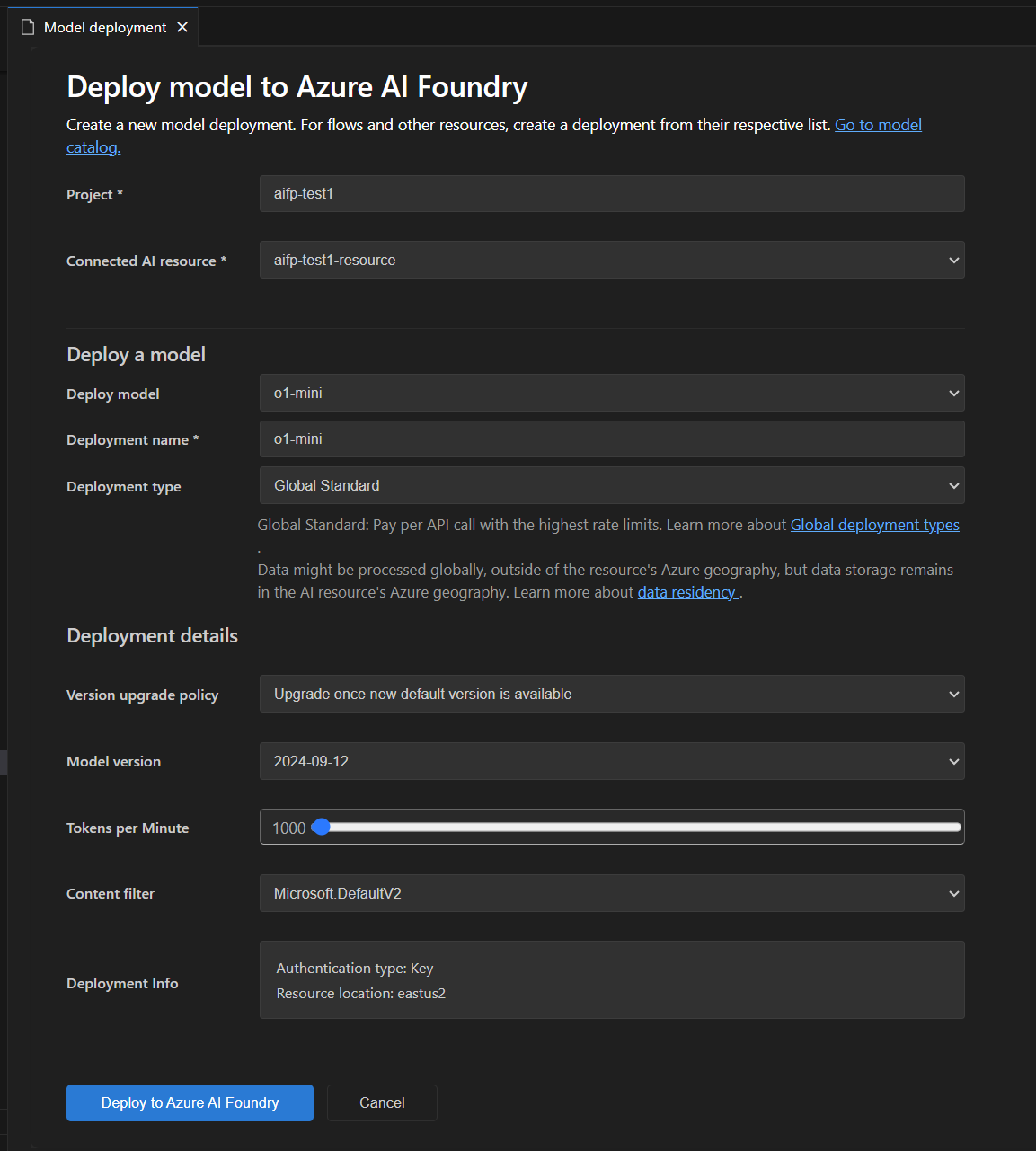

将模型部署到 Microsoft Foundry

您可以直接从 AI Toolkit 将模型部署到 Microsoft Foundry。这允许您在云中运行模型并通过端点访问它。

-

在模型目录中,选择要部署的模型。

-

从下拉菜单或直接从 Deploy to Microsoft Foundry 按钮中选择 Deploy to Microsoft Foundry,如下图所示

-

在 model deployment 选项卡中,输入所需信息,例如模型名称、描述以及任何其他设置,如下图所示

-

选择 Deploy to Microsoft Foundry 开始部署过程。

-

将出现一个对话框以确认部署。检查详细信息并选择 Deploy 继续。

-

部署完成后,模型将在 AI Toolkit 的 MY MODELS 部分可用,您可以在 Playground 或 Agent Builder 中使用它。

选择模型进行测试

您可以在 Playground 中测试模型以进行聊天补全。

使用模型目录中模型卡片上的操作

- Try in Playground:将选定的模型加载到 Playground 中进行测试。

- Try in Agent Builder:将选定的模型加载到 Agent Builder 中以构建 AI 代理。

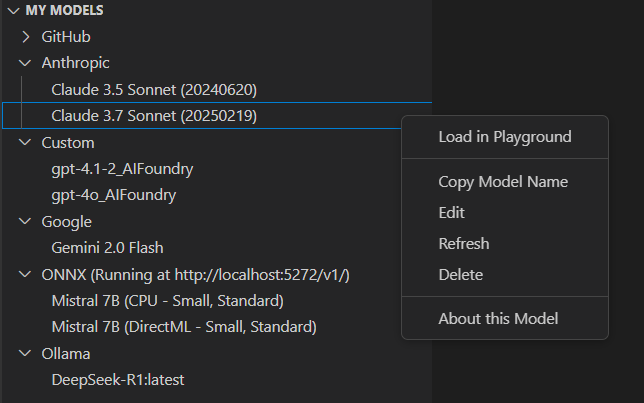

管理模型

您可以在 AI Toolkit 视图的 MY MODELS 部分管理您的模型。在这里您可以

-

查看已添加到 AI Toolkit 的模型列表。

-

右键单击模型以访问选项,例如

- Load in Playground:将模型加载到 Playground 中进行测试。

- Copy Model Name:将模型名称复制到剪贴板,以便在其他上下文中使用,例如您的代码集成。

- Refresh:刷新模型配置,以确保您拥有最新的设置。

- Edit:修改模型设置,例如 API 密钥或端点。

- Delete:从 AI Toolkit 中删除模型。

- About this Model:查看有关模型的详细信息,包括其发布商、来源和支持的功能。

-

右键单击

ONNX部分标题以访问选项,例如- Start Server:启动 ONNX 服务器以在本地运行 ONNX 模型。

- Stop Server:停止正在运行的 ONNX 服务器。

- Copy Endpoint:将 ONNX 服务器端点复制到剪贴板,以便在其他上下文中使用,例如您的代码集成。

许可和登录

某些模型需要发布商或许可服务许可证和账户才能登录。在这种情况下,在您可以在 模型 Playground 中运行模型之前,系统会提示您提供此信息。

您学到了什么

在本文中,您学习了如何

- 在 AI Toolkit 中探索和管理生成式 AI 模型。

- 从各种来源查找模型,包括 GitHub、ONNX、OpenAI、Anthropic、Google、Ollama 和自定义端点。

- 将模型添加到您的工具包并将其部署到 Microsoft Foundry。

- 添加自定义模型,包括 Ollama 和 OpenAI 兼容模型,并在 Playground 或 Agent Builder 中进行测试。

- 使用模型目录查看可用模型,并为您的 AI 应用需求选择最合适的模型。

- 使用筛选器和搜索快速查找模型。

- 按类别浏览模型,例如热门模型、GitHub 模型、ONNX 模型和 Ollama 模型。

- 使用模型转换工具转换和添加自定义 ONNX 模型。

- 在 MY MODELS 中管理模型,包括编辑、删除、刷新和查看详细信息。

- 启动和停止 ONNX 服务器,并为本地模型复制端点。

- 在测试某些模型之前,处理其许可和登录要求。