开源 AI 编辑器:第二个里程碑

VS Code 团队于 2025 年 11 月 6 日发布

在 五月,我们公布了将 VS Code 打造成开源 AI 编辑器的初步计划,并在 六月,通过开源 GitHub Copilot Chat 扩展,实现了第一个里程碑。

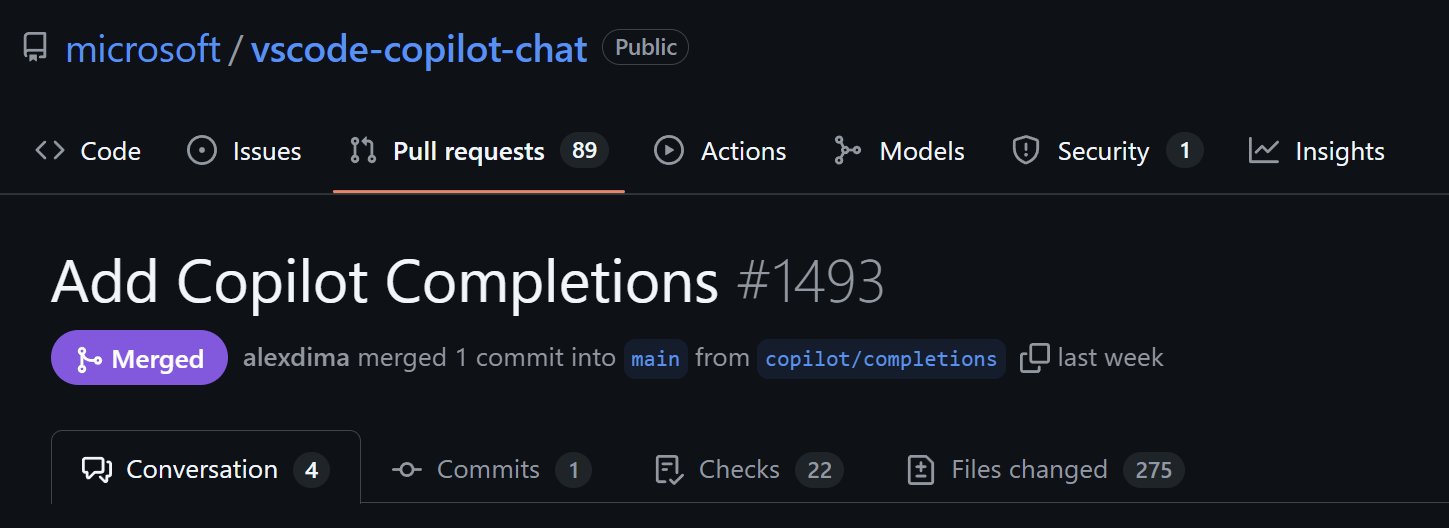

虽然聊天功能是向前迈出的重要一步,但我们 AI 功能中仍有一个重要部分:您在键入时出现的内联建议。今天,我们在这个旅程中达到了下一个里程碑:内联建议现已开源。

一个扩展,相同的用户体验

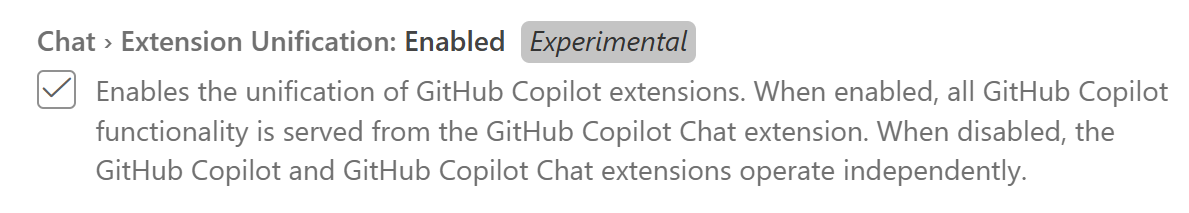

在过去的几年里,VS Code 中的 GitHub Copilot 分成了两个扩展:GitHub Copilot 扩展(用于代码补全建议)和 GitHub Copilot Chat 扩展(用于聊天和下一个编辑建议)。我们正致力于在一个 VS Code 扩展中提供所有 Copilot 功能:Copilot Chat。

为了实现这一目标,我们现在正在测试禁用 Copilot 扩展,并从 Copilot Chat 提供所有内联建议。我们已将绝大多数功能移植到 chat 扩展,因此,单个扩展体验的渐进式推出对每个人来说都应该感觉一致且透明。

您的体验不应有任何改变。您将继续在键入时获得相同的智能代码建议,以及您已经使用的所有聊天和代理模式功能。如果您遇到任何问题,请报告问题,或者如果需要,请参阅如何使用之前的体验。

作为此次重构的一部分,GitHub Copilot 扩展将于 2026 年初被弃用,这意味着它将从 VS Code Marketplace 中移除。

我们还简化了术语:我们现在使用内联建议来指代您在键入时出现的所有 AI 生成的代码建议(包括代码补全建议和下一个编辑建议)。我们将继续努力统一实际的产品体验,包括不同类型建议的用户体验和时机。

探索与贡献

随着内联建议在 vscode-copilot-chat 仓库中可用,您可以探索并贡献于它们的工作方式

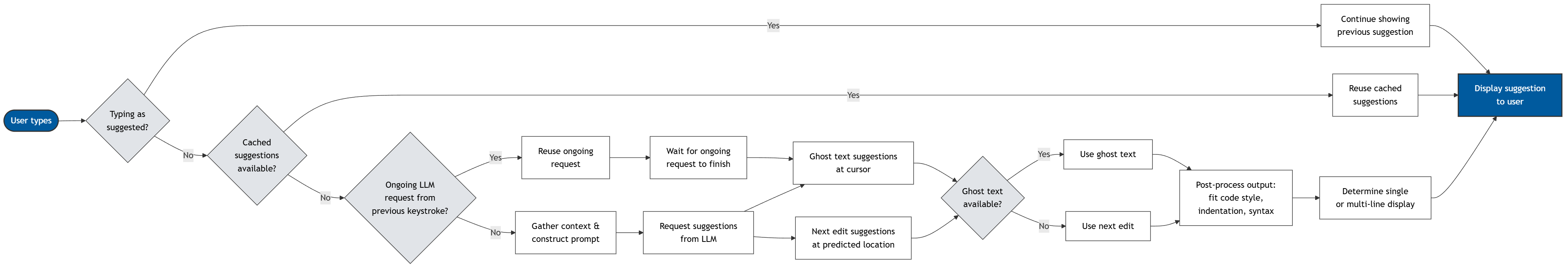

- “按建议键入”检测 - 在您键入时,扩展会首先检查您是否遵循了之前的建议,并可以在不发出新请求的情况下继续显示它

- 缓存 - 如果不是按建议键入,扩展会检查是否可以重用缓存的建议以提高性能

- 重用进行中的请求 - 如果没有可用的缓存建议,扩展会检查前一个按键是否有一个尚未完成流式传输的 LLM 请求。由于此进行中的请求可能与当前请求类似,因此扩展会重用它,而不是启动新请求并取消进行中的请求,这会显着提高性能

- 提示构建 - 如果无法重用进行中的请求,扩展会从当前文件、打开的文件和工作区中收集相关上下文,然后将其格式化为提示发送给 LLM

- 模型推理 - 扩展会从多个提供程序请求内联建议:针对当前光标位置的代码补全建议,以及预测您可能接下来编辑位置的下一个编辑建议。当有可用的代码补全建议时,会优先显示;否则,会使用下一个编辑建议

- 后处理 - 对原始模型输出进行精炼,以确保它们符合您的代码风格、缩进和语法

- 多行智能 - 扩展会根据置信度和上下文决定显示单行还是多行

性能改进

除了合并到一个扩展之外,此次重构还为内联建议带来了技术上的改进

- 降低延迟 - 我们修复了网络问题,以优化建议的交付方式,使 chat 扩展能够更快地提供代码补全建议

- 质量验证 - 我们进行了广泛的实验,以确保在延迟或建议质量方面没有出现回归

故障排除

与所有更改一样,尽管我们尽了最大努力,但仍有可能遗漏一些东西!如果您在统一的扩展体验中遇到任何问题,可以通过取消选中统一设置来暂时恢复到之前的两个扩展行为

下一步是什么?

我们 OSS 之旅的下一阶段是将 Copilot Chat 扩展中的一些 AI 功能和组件重构到 VS Code 核心。我们很高兴与社区一起继续这段旅程,并作为一个开源 AI 编辑器塑造开发行业的未来。

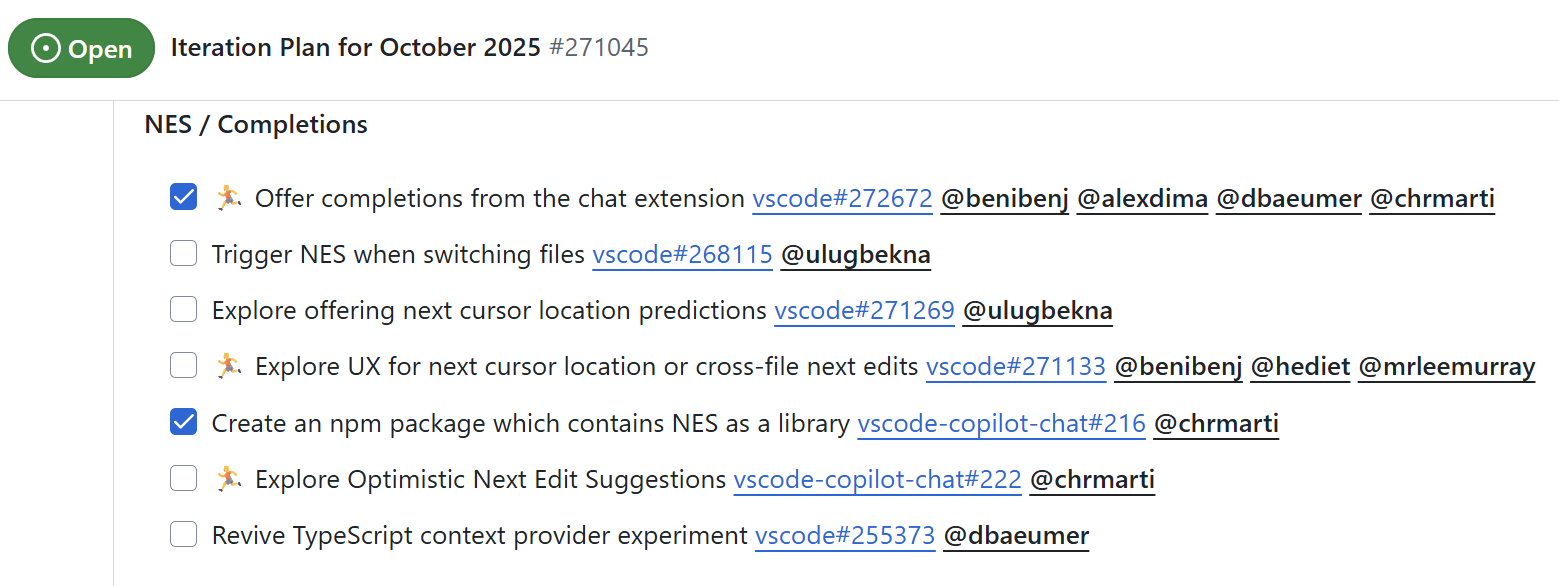

我们将继续积极改进我们的内联建议体验 - 一如既往,您可以在我们的迭代计划中了解最新动态

编码愉快!💙

VS Code 团队