通过自带密钥扩展 VS Code 中的模型选择

2025 年 10 月 22 日,作者:Olivia Guzzardo McVicker、Pierce Boggan

我们知道模型选择对您很重要。我们的团队一直在努力,以便在同一天将 Claude Haiku 4.5 和 GPT 5 等最新模型提供给您。但我们也听取了您的反馈,您希望在 VS Code 中支持更多模型,无论是在本地还是在云端。

三月份,我们发布了自带密钥 (BYOK) 功能,让您可以从 OpenRouter、Ollama、Google、OpenAI 等支持提供商的数百种模型中进行选择,为 VS Code 中的聊天体验提供支持。

现在,我们将 BYOK 推向了新的高度。在 v1.104 版本中,我们引入了语言模型聊天提供商 API,使模型提供商可以直接通过 VS Code 扩展贡献他们的模型。

什么是自带密钥 (BYOK)?

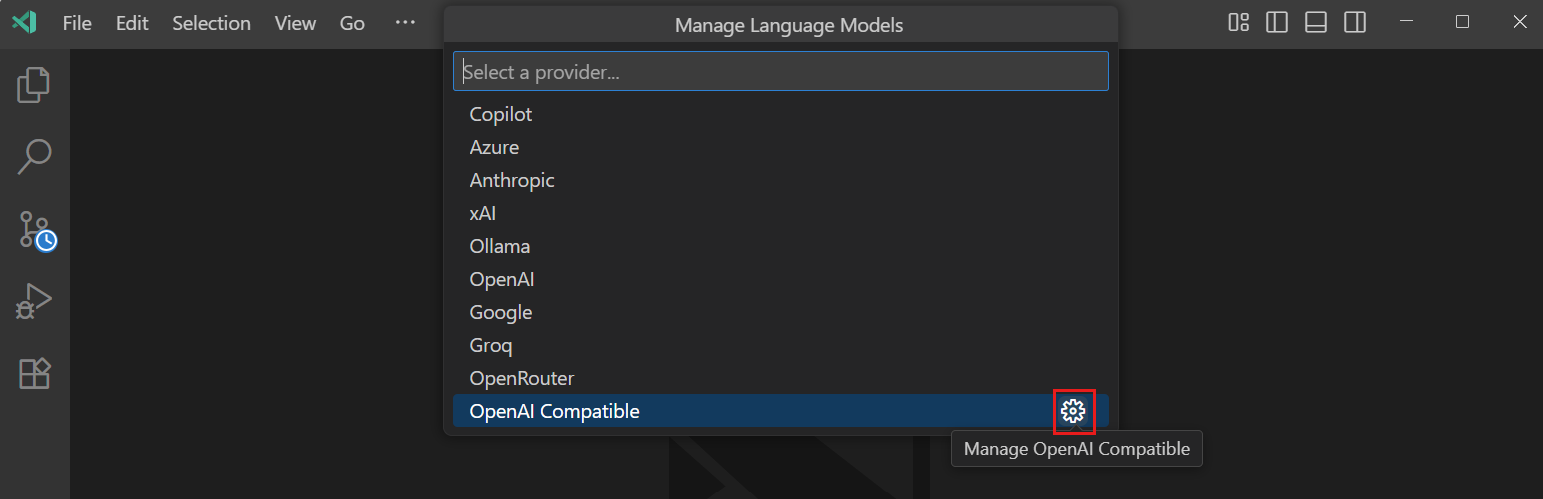

BYOK 允许您通过提供支持提供商的 API 密钥来使用该提供商的任何模型。这意味着您可以访问 VS Code 内置模型之外的庞大模型生态系统。无论您是想使用专门的代码生成模型,还是用于通用聊天的不同模型,或是通过 Ollama 等提供商尝试本地模型,BYOK 都可以通过您的 API 密钥实现。您可以通过 **Chat: Manage Language Models** 命令进行配置。

但是,管理不断增长的支持提供商列表对用户和我们的团队都带来了挑战。因此,我们发布了语言模型聊天提供商 API,允许模型提供商直接通过 VS Code 扩展贡献他们的模型。

语言模型聊天提供商 API

语言模型聊天提供商 API 将 BYOK 从集中式系统转变为一个开放、可扩展的生态系统,任何提供商都可以通过简单的扩展安装来提供他们的模型。我们将继续支持一部分内置提供商,但这个可扩展的生态系统将使我们能够扩展模型选择,以满足开发者的需求。

通过语言模型聊天提供商 API 提供的模型目前可供使用个人 GitHub Copilot 计划(免费、Pro 和 Pro+)的用户使用。

以下是我们现在可以安装的您最喜欢的几个扩展,可用于在 VS Code 中访问更多模型:

-

Visual Studio Code 的 AI 工具包扩展让您可以直接在 VS Code 中访问其提供的模型,无论是您在 Azure AI Foundry 中微调的自定义模型、通过 Foundry Local 的本地模型,还是 GitHub Models 中的任何模型。

-

Cerebras Inference 支持世界顶级的编码模型,使代码生成几乎即时完成,非常适合快速迭代。它以 2000 tokens/s 的速度运行 Qwen3 Coder 和 GPT OSS 120B,速度比大多数推理 API 快 20 倍。

-

GitHub Copilot Chat 扩展的 Hugging Face 提供商使您能够在 VS Code 中直接使用 Kimi K2、DeepSeek V3.1、GLM 4.5 等前沿开放 LLM。Hugging Face 的推理提供商使开发人员能够访问数百个 LLM,这些 LLM 由世界一流的推理提供商提供支持,并针对高可用性和低延迟进行了优化。

对于有兴趣贡献自己模型的扩展开发者,请查看我们的 语言模型聊天提供商 API 文档 和 示例扩展,立即开始构建。

OpenAI 兼容模型

对于使用 OpenAI 兼容模型的开发者,您可以使用自定义 **OpenAI 兼容**提供商来连接任何 OpenAI 兼容的 API 端点,并为聊天配置模型。此功能目前仅在 VS Code Insiders 中可用。

此外,您还可以通过 github.copilot.chat.customOAIModels 设置显式配置编辑工具列表,从而对自定义模型可用的功能进行精细控制。

下一步是什么?

语言模型聊天提供商 API 只是为您带来更多模型选择的开端。随着这个生态系统的发展,我们预计将看到:

- 允许您了解模型功能和管理模型的模型管理 UI

- 安装贡献语言模型的扩展的更流畅流程

- 改进内置语言模型提供商,使用最新的提供商 API 并针对不同模型进行专门提示

我们正在持续投资 BYOK 体验。 最近的增强功能包括改进的编辑工具,以更好地与 VS Code 的内置工具集成,但我们知道还有很多工作要做,才能使体验感觉更原生于 VS Code——例如,BYOK 目前不适用于自动补全。我们很乐意在我们的 GitHub 存储库上听到您的反馈!

编程愉快!